- 概要

- スタートアップガイド

- ユーザガイド

-

リファレンス

-

ABEJA Platform CLI

- CONFIG COMMAND

- DATALAKE COMMAND

- DATASET COMMAND

- TRAINING COMMAND

-

MODEL COMMAND

- check-endpoint-image

- check-endpoint-json

- create-deployment

- create-endpoint

- create-model

- create-service

- create-trigger

- create-version

- delete-deployment

- delete-endpoint

- delete-model

- delete-service

- delete-version

- describe-deployments

- describe-endpoints

- describe-models

- describe-service-logs

- describe-services

- describe-versions

- download-versions

- run-local

- run-local-server

- start-service

- stop-service

- submit-run

- update-endpoint

- startapp command

- SECRET COMMAND

- SECRET VERSION COMMAND

-

ABEJA Platform CLI

- FAQ

- Appendix

テンプレート デプロイメント (Object Detection)

はじめに

このドキュメントでは、ABEJA Templateを利用して、Object Detectionの推論APIをノンコーディングで作成する方法を解説します。

学習モデルを用意する

Object Detectionの学習モデルを用意します。ABEJA Template (Object detection) を用いた学習モデルの作成方法はこちらに記載しています。

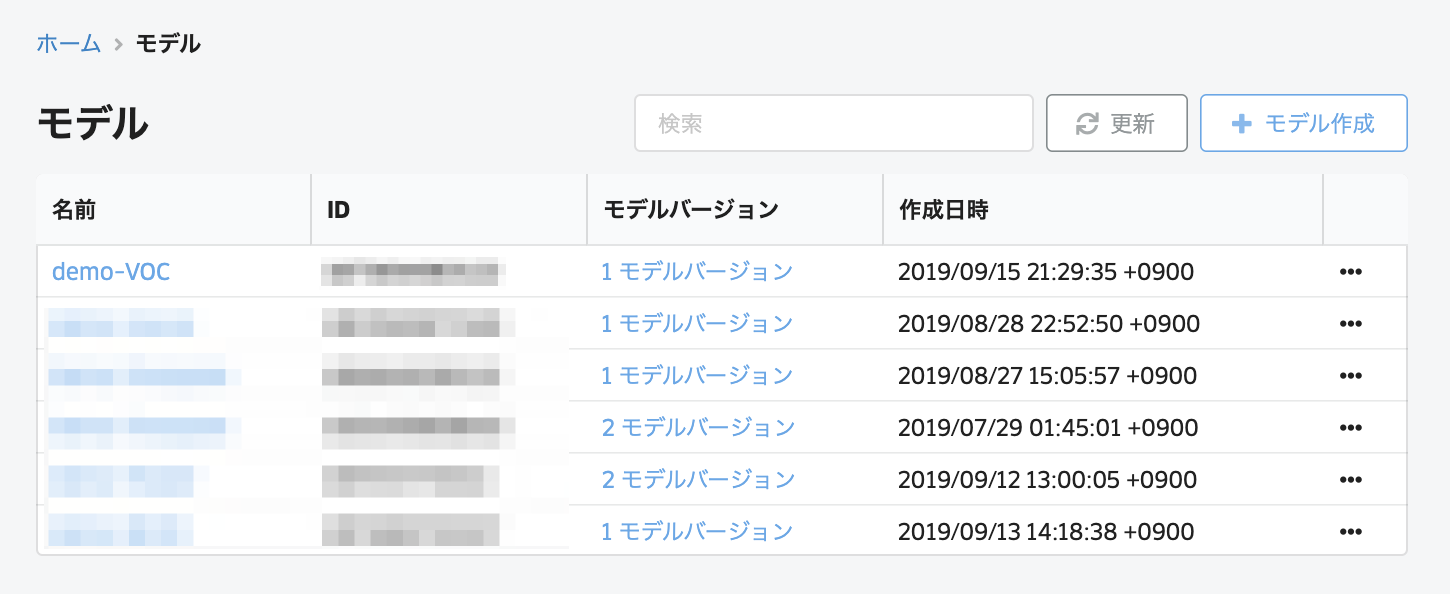

モデルを管理する

コンソールの「モデル」から「モデルの作成」をクリックして、モデルを作成します。

モデル作成画面では、以下の項目を選択します。

| 項目 | 説明 |

|---|---|

| 名前 | モデルの名前 |

| 詳細 | モデルの詳細 |

| バージョン | モデルの管理バージョン |

| 作成後にデプロイメント | モデルが作成されたタイミングでデプロイを実施する場合はチェック |

| デプロイメント名 | デプロイを実施する場合、デプロイメント名を入力 |

| テンプレート | 「Object Detection(CPU)」を選択 |

| ジョブ定義 | 学習時に利用したジョブ定義を選択 |

| 学習ジョブ | デプロイを実施したい学習ジョブを選択 |

これでデプロイの準備ができました。

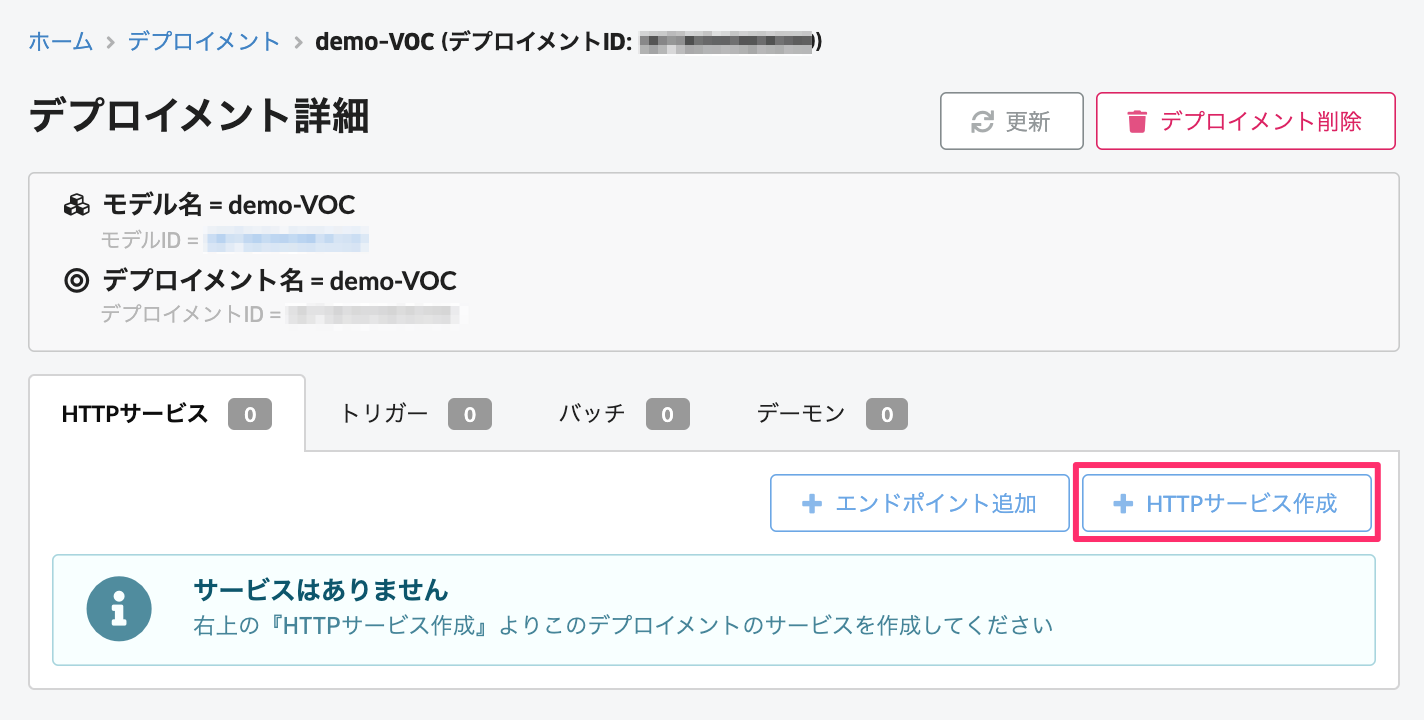

HTTPサービスの作成

コンソールの「デプロイメント」に移動すると、先ほど作成したデプロイメント名で作成されています。

デプロイメントの名前をクリックして、「HTTPサービスを作成」をクリックします。バージョンとインスタンスタイプ、インスタンス数を選択します。

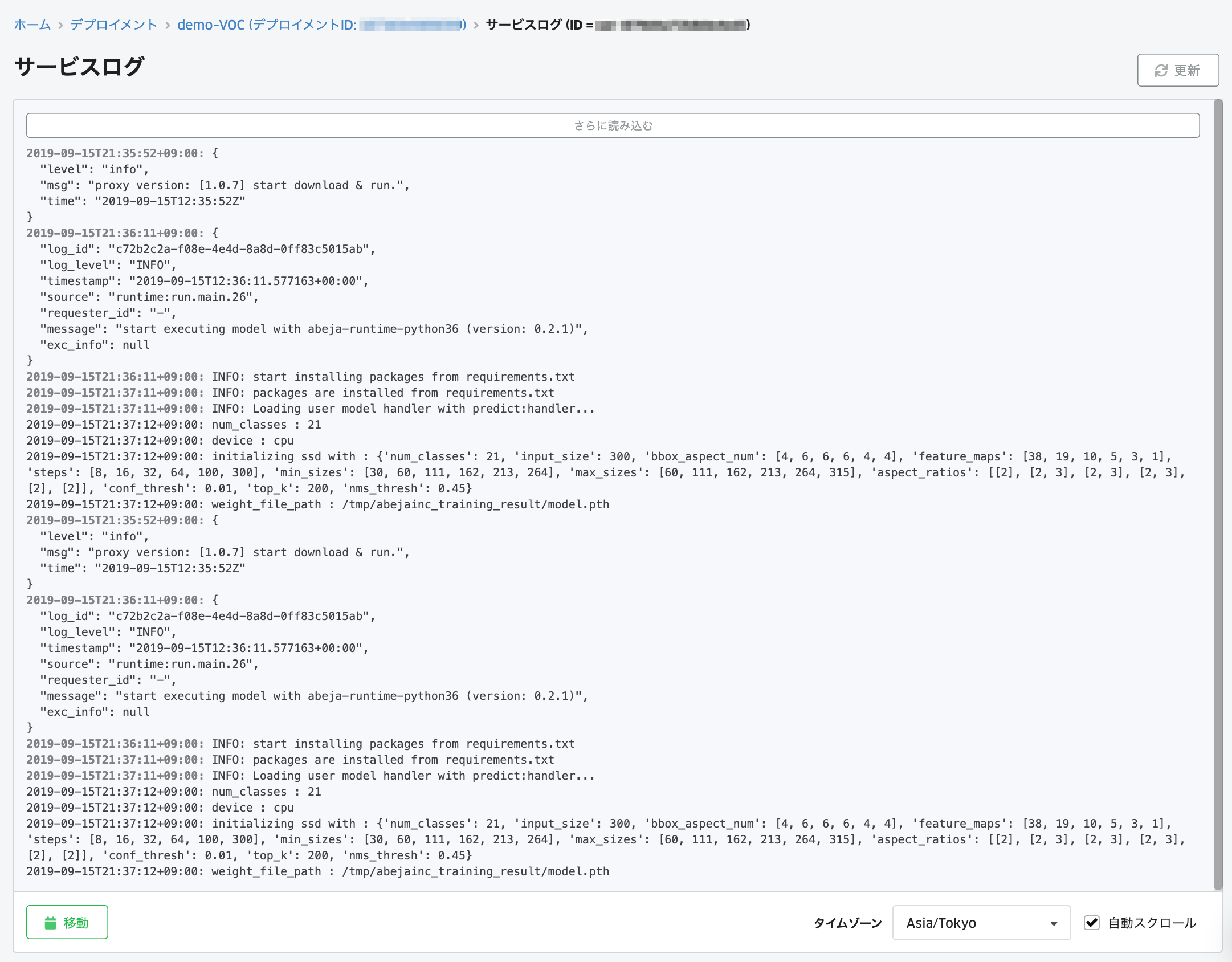

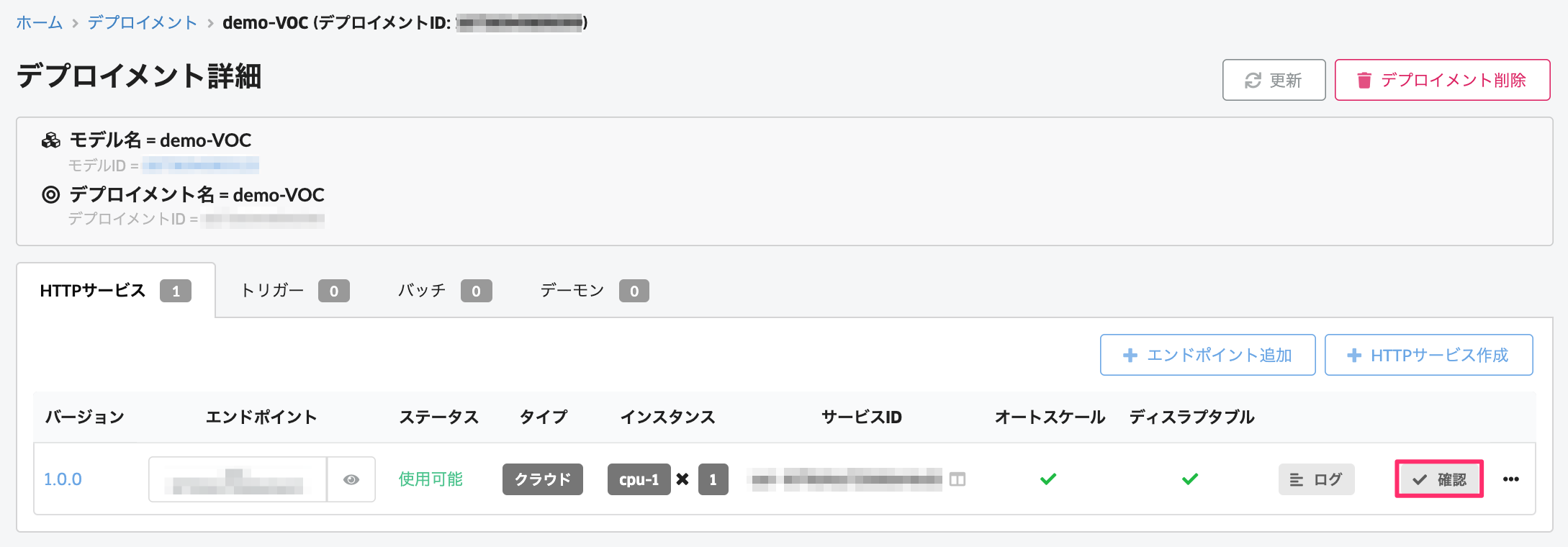

数分待つと、ステータスが「使用可能」となり、モデルがWeb APIとしてデプロイされます。これでデプロイ完了です。 デプロイ処理中は、「ログ」のボタンを選択することで、デプロイ時のログが確認可能です。

動作確認

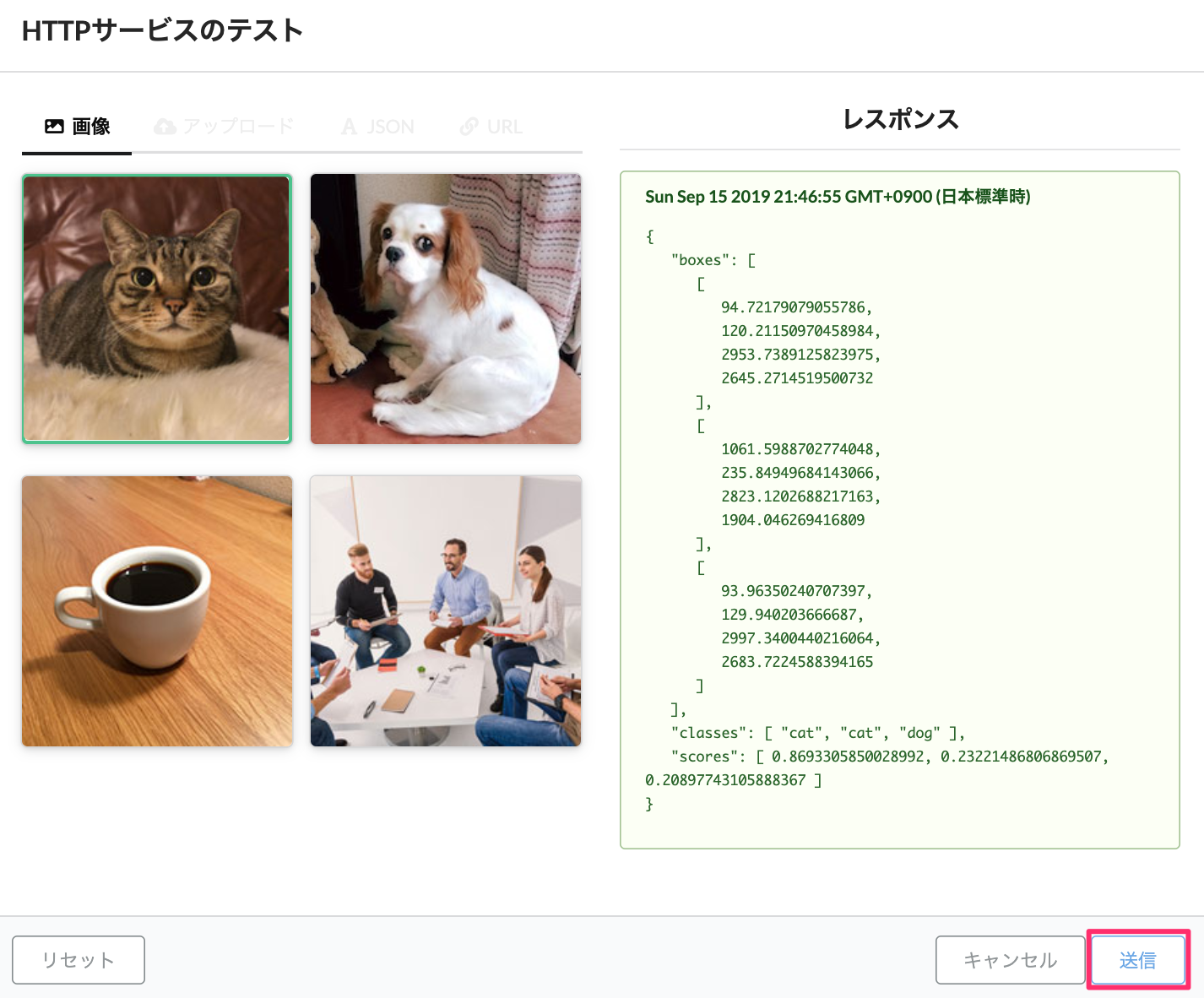

「✔︎確認」をクリックして、テストを行います。ここでは、サンプルの「猫」の写真で動作確認をします。

「猫」の画像を選択し、「送信」をクリックすると、推論結果が返ってきます。この場合、boxesの座標情報と、Classesとして「cat」がScoresが86.93%と推論結果が返ってきていることがわかります。

本ページでは、ABEJA Template (Object Detection)を利用したデプロイメント方法について紹介しました。