- 概要

- スタートアップガイド

- ユーザガイド

-

リファレンス

-

ABEJA Platform CLI

- CONFIG COMMAND

- DATALAKE COMMAND

- DATASET COMMAND

- TRAINING COMMAND

-

MODEL COMMAND

- check-endpoint-image

- check-endpoint-json

- create-deployment

- create-endpoint

- create-model

- create-service

- create-trigger

- create-version

- delete-deployment

- delete-endpoint

- delete-model

- delete-service

- delete-version

- describe-deployments

- describe-endpoints

- describe-models

- describe-service-logs

- describe-services

- describe-versions

- download-versions

- run-local

- run-local-server

- start-service

- stop-service

- submit-run

- update-endpoint

- startapp command

- SECRET COMMAND

- SECRET VERSION COMMAND

-

ABEJA Platform CLI

- FAQ

- Appendix

デプロイメント

はじめに

このドキュメントでは、ABEJA Template を利用して、ノンコーディングで推論用のAPIサービスを立ち上げます。今回はImage Classificationのタスクを用います。

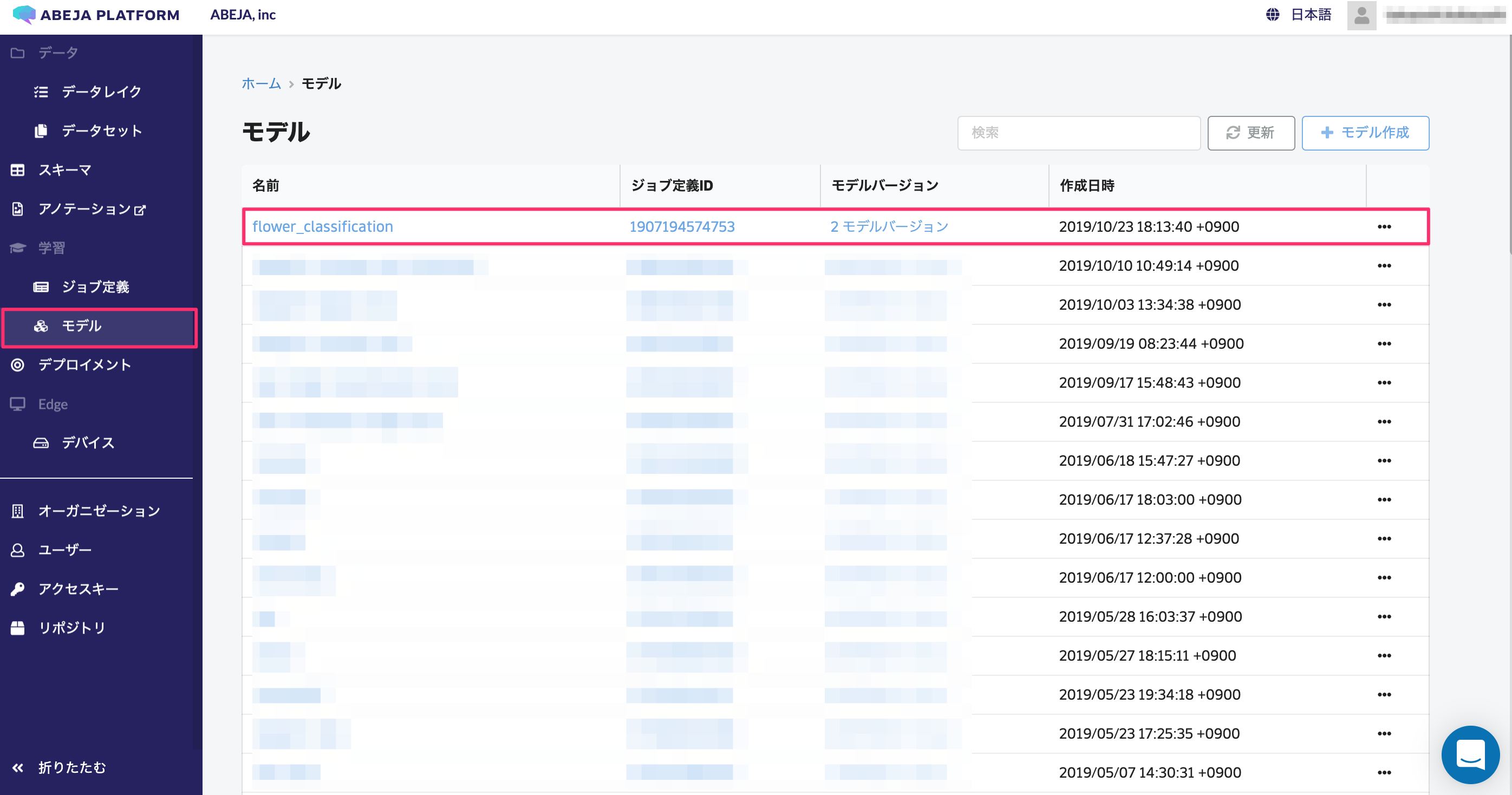

学習モデルの確認

学習モデルを確認します。学習モデルの作成方法はこちらに記載しています。

「モデル」をクリックすると、先程、学習ジョブを実施した結果が反映されています。このモデルを利用し、推論モデルAPIをデプロイしていきます。

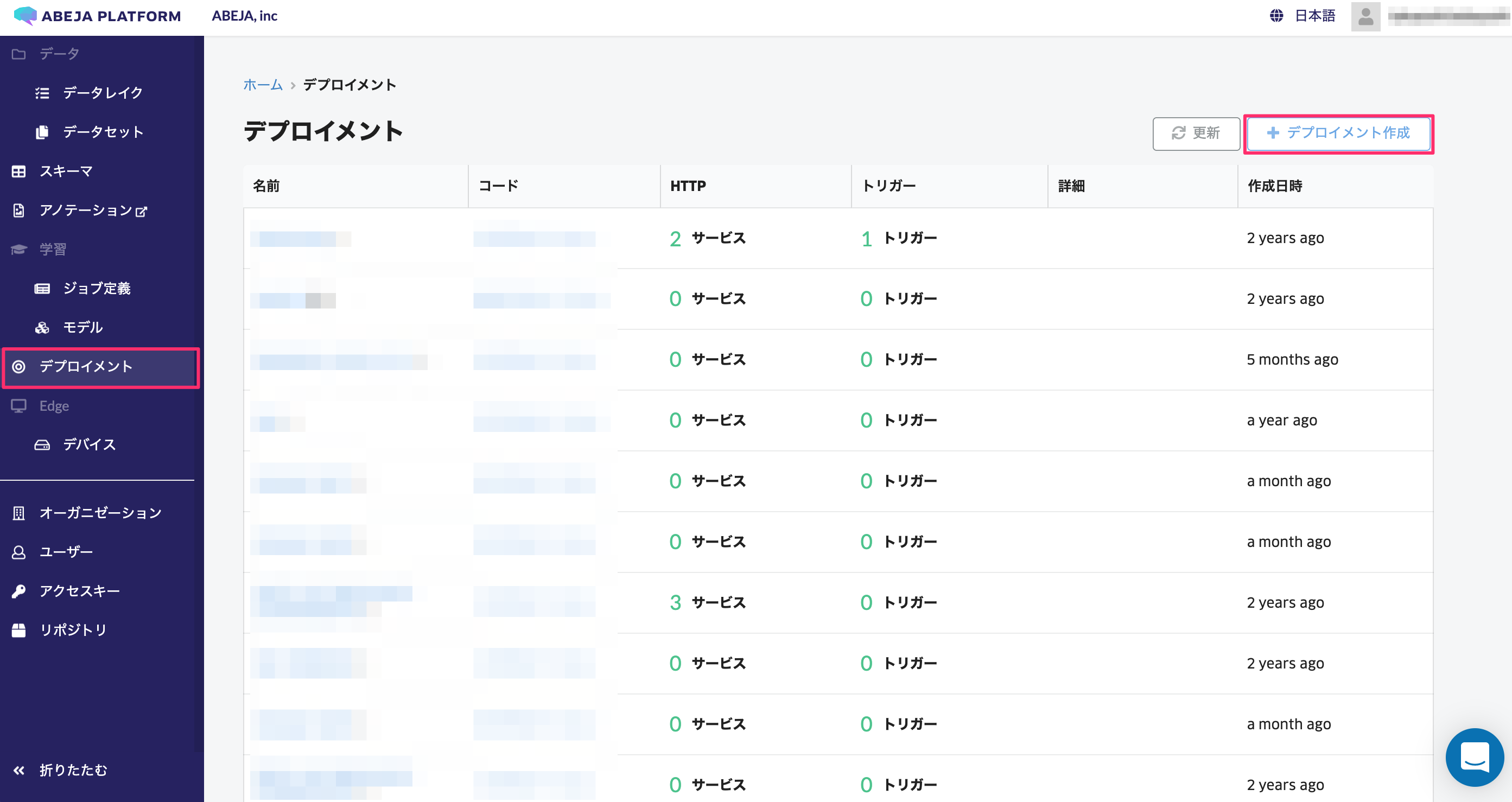

デプロイメントの作成

まず、推論APIを作成するための枠 (デプロイメント) を作成します。デプロイメントでは、学習で作成されたモデルと、推論を実施するためのコードを管理し、APIサービスを提供します。

左のメニューより「デプロイメント」を選択します。その後、「デプロイメント作成」を選択します。

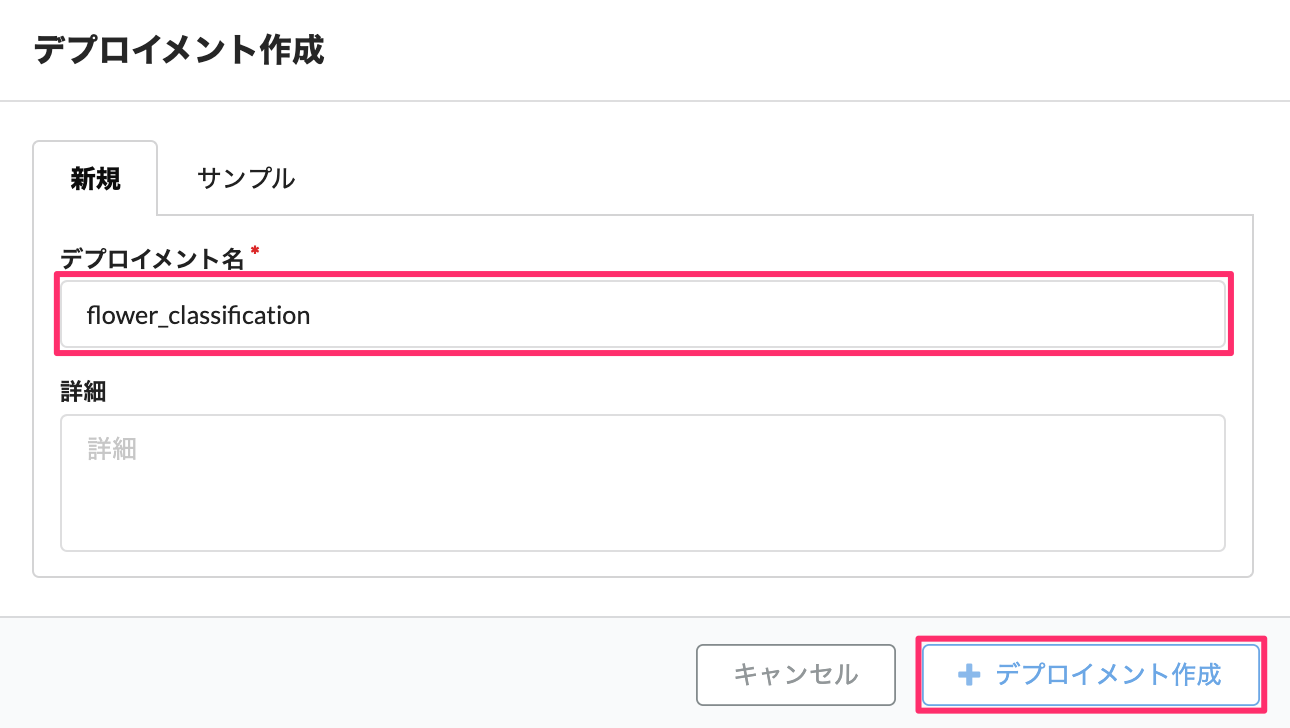

デプロイメントの作成では、「デプロイメント名」と「詳細」が入力可能です。

入力後、「デプロイメント作成」を選択します。

これで、デプロイを管理するための枠が作成されました。

推論コードを作成する

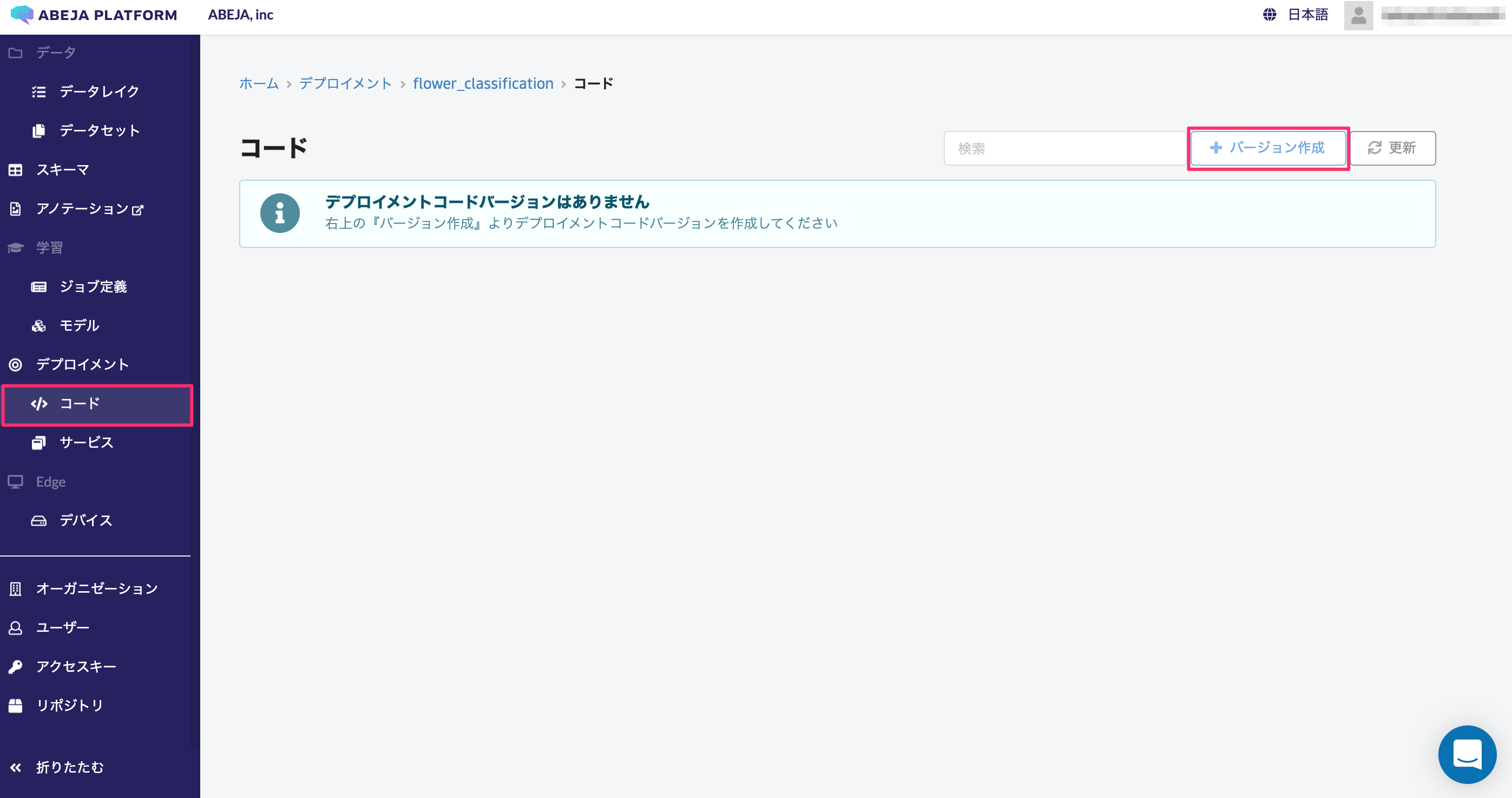

次に、推論を実施するためのコードを管理します。左メニューより「コード」を選択します。

ここでは、作成した推論コードを持ち込んだり、ABEJAより提供しているテンプレートを利用することが可能です。 今回は、テンプレートを利用した推論コードを作成します。

「バージョン作成」を選択します。

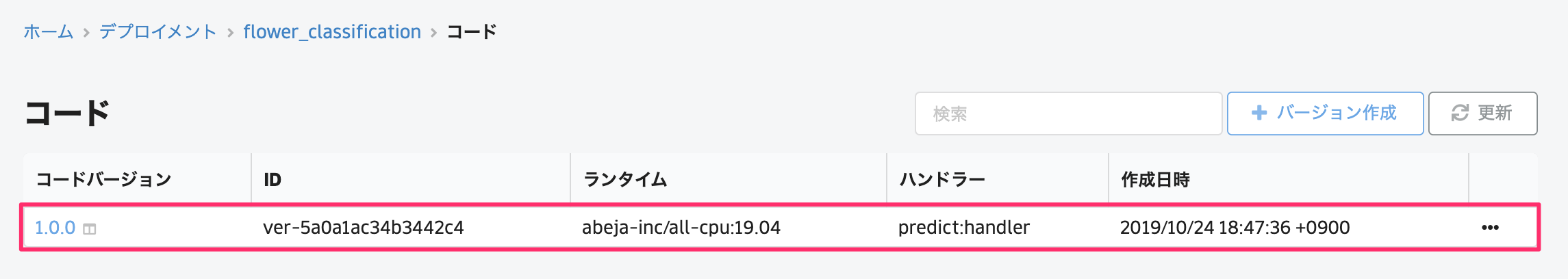

「テンプレート」を選択し、管理するバージョンを入力、「作成する」を選択します。

これでデプロイメントに使用する「コード」が作成され、APIサービスのデプロイの準備が整いました。

HTTPサービスの作成

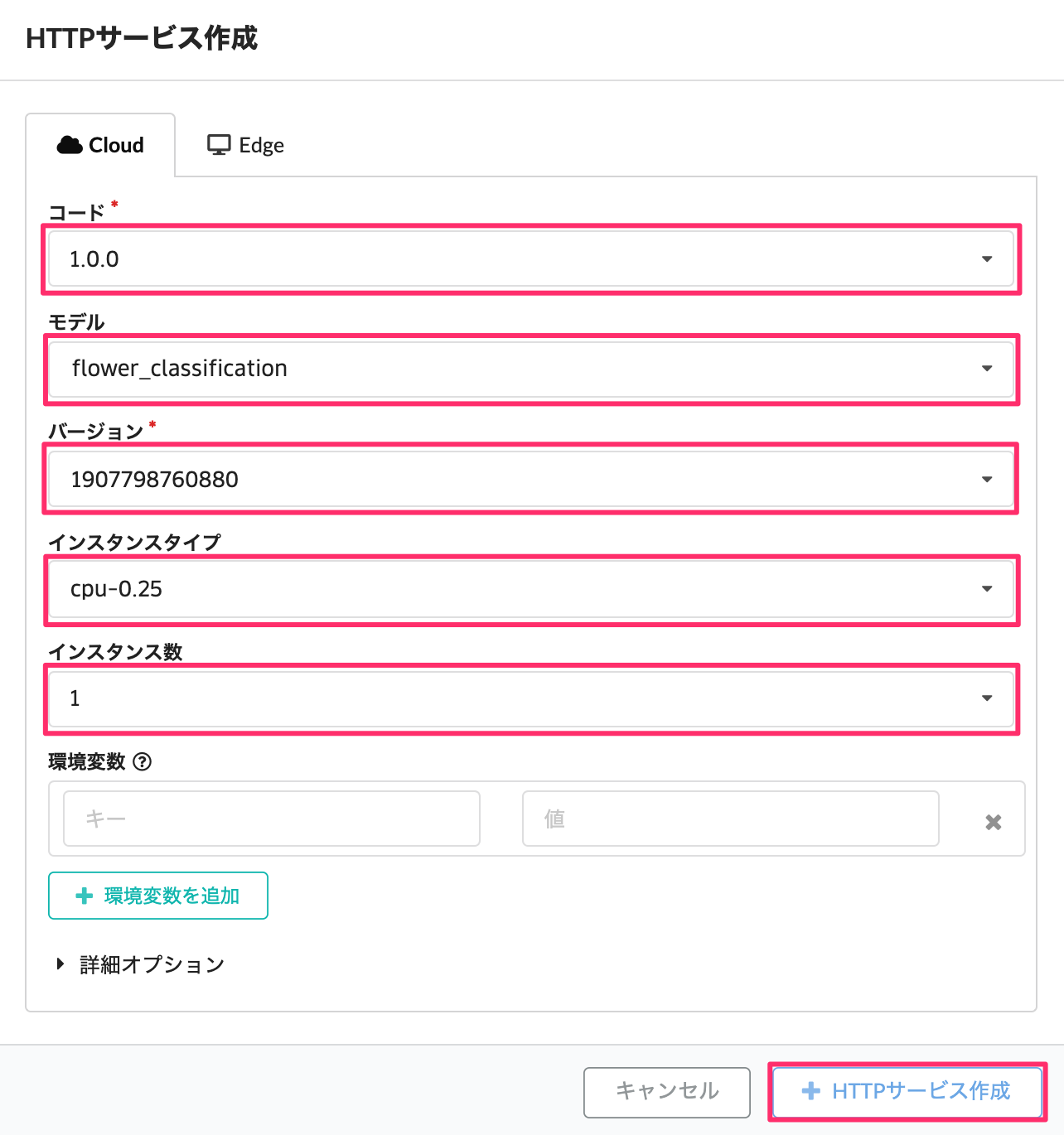

次に、先程作成した「コード」と「モデル」を使用してAPIサービスをデプロイします。ここでは、HTTPサービスの作成方法を解説します。

左メニューの「サービス」を選択し、「HTTPサービス作成」を選択します。

次に、作成したコードのバージョン・モデル・モデルのバージョン・インスタンスタイプ・インスタンス数を選択し、「HTTPサービスの作成」を選択します。

数分待つと、ステータスが「使用可能」になり、モデルがWeb APIとしてデプロイされます。学習が完了してから、わずか数分間でモデルをデプロイできました。

動作確認

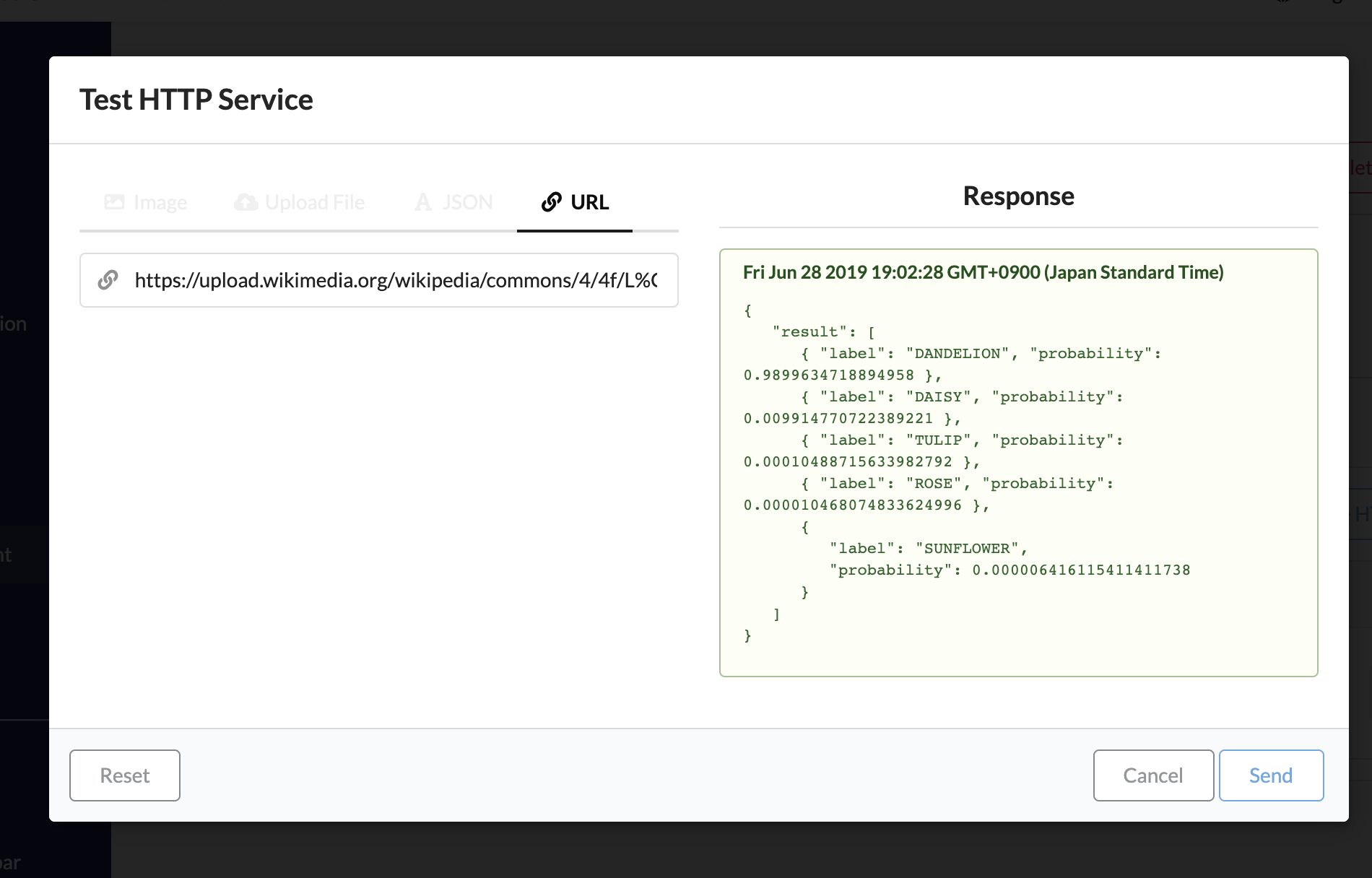

「✔︎確認」をクリックして、テストを行います。URLをクリックして、Wikipediaのタンポポの写真のリンクを貼ります。

送信をクリックすると、推論結果が返ってきます。前節で作った学習モデルだと、Probabilityが98.99%で、DANDELION(タンポポ)と予測しています。